Todo mundo falando do ChatGPT e das maravilhas que a nova e imbatível inteligência artificial é capaz de produzir. Uma pequena passeada na internet e você é bombardeado com centenas de publicações e manifestações sobre os resultados incríveis da tecnologia e como milhões de empregos estão ameaçados.

A conclusão a que você é chamado a concluir é que a revolução das máquinas chegou!

Eu, que não sou curioso demais, mas também não sou o retardatário da fila, fui lá dar uma olhada no que é esse negócio. E em tudo que eu desconheço tenho sempre a mesma métrica: como bom mineiro, vou tateando pelas beiradas até entender a “fundura do poço”.

E como fazer isso? Começando pelo começo! E o começo é o que se convencionou chamar de bê-á-bá. Essa expressão esquisita se refere aos primeiros passos da alfabetização de uma criança, onde se aprende o significado das letras para juntar umas com as outras e formar palavrinhas.

Parêntesis 1: isso é conversa para boi dormir. Imagina explicar para uma criança de 4/5 anos (quando aprendi a ler e escrever) que a primeira letra do nome dela não tem som, não é pronunciada, mas também não pode ser excluída do nome? Obviamente que deu muito errado por muito tempo.

Voltando: obviamente que para uma inteligência artificial eu não ia perguntar as letras do alfabeto, mas o meu bê-á-bá, que nada mais é do que aquele conjunto de temas em que tenho a maior segurança. Então comecei a fazer umas perguntas bem objetivas para a IA em matéria jurídica, de modo a perceber se realmente o trabalho dos advogados está ameaçado.

O resultado não me deixou surpreso. Muito afirmações assertivas e construções bem objetivas com respostas rápidas e com indicação de leis. Perguntei quais eram os fundamentos legais para tratamento de dados pessoais de acordo com a lei brasileira. A resposta veio redondinha.

Solicitei que a IA construísse uma cláusula de confidencialidade contratual com os itens necessários para salvaguardar informações sensíveis. Novo acerto.

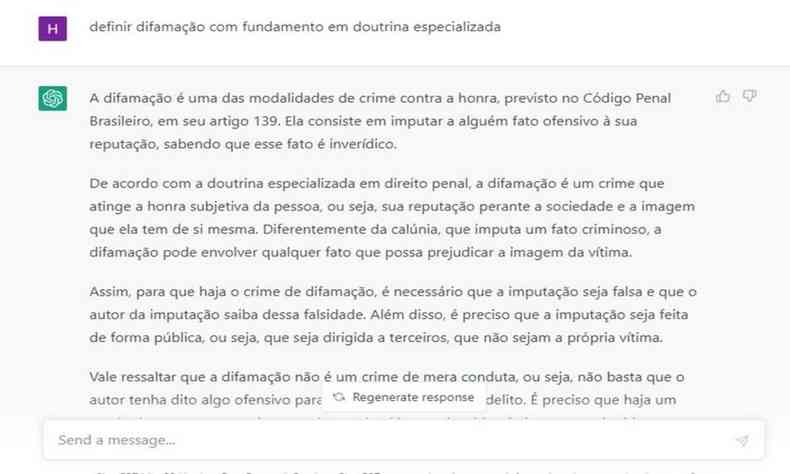

Resolvi mudar de assunto e pedi a definição do crime de difamação (adoro crimes contra a honra). E aí, para a minha surpresa, o ChatGPT escorregou na banana. Errou feio, errou rude, e mesmo eu tentando ajudar só piorou.

Dá uma olhada na definição que ele mandou:

Essa parte do conceito de que a difamação consiste em uma informação sabidamente falsa está completamente errada! Na verdade, é o contrário! A difamação pode consistir em afirmação falsa ou verdadeira, desde que não constitua a descrição de conduta tipificada como crime. O pressuposto aqui é o dolo de atingir a honra objetiva (imagem perante terceiros) da vítima.

Daí a IA erra de novo, pois afirma que a lesão causada pela difamação é à honra subjetiva, quando na verdade é à honra objetiva. A honra subjetiva é atingida pela conduta caracterizada como injúria.

Ou seja, a resposta da IA está miseravelmente errada! E está errada no nível erro grosseiro, desses que aparecem como meme na internet e viram chacota lá no Juizado Especial Criminal, que é, de regra, o foro competente para processar e julgar estas imputações.

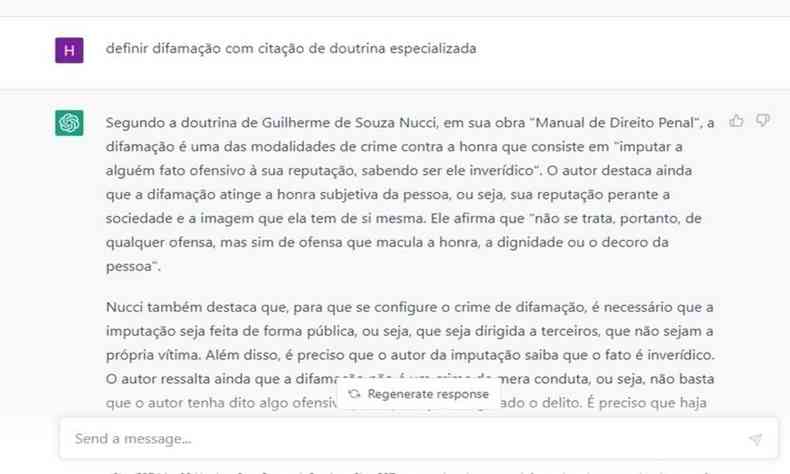

Daí então eu resolvi tentar dar uma ajudinha para o ChatGPT e repeti a mesma pesquisa, mas agora pedindo a citação de doutrina especializada. O resultado foi bizarramente catastrófico!

Dá uma olhada no que a IA me respondeu:

Ou seja, a IA acabou de vender a preço de ovo podre o Manual de Direito Penal do Guilherme de Souza Nucci!

As pessoas que tiverem a curiosidade de passar os olhos na obra do referido autor (que é vasta, conhecida e amplamente citada em artigos, livros e decisões dos tribunais), vai descobrir que o autor fala um pouco diferente:

“Difamar significa desacreditar publicamente uma pessoa, maculando-lhe a reputação. Nesse caso, mais uma vez, o tipo penal foi propositadamente repetitivo. Difamar já significa imputar algo desairoso a outrem, embora a descrição abstrata feita pelo legislador tenha deixado claro que, no contexto do crime do art. 139, não se trata de qualquer fato inconveniente ou negativo, mas sim de fato ofensivo à sua reputação. Com isso, excluiu os fatos definidos como crime – que ficaram para o tipo penal da calúnia – bem como afastou qualquer vinculação à falsidade ou veracidade dos mesmos. Assim, difamar uma pessoa implica divulgar fatos infamantes à sua honra objetiva, sejam eles verdadeiros ou falsos.” (NUCCI, Guilherme de Souza. Manual de Direito Penal. 16. ed. Rio de Janeiro: Forense, 2020). (sem grifos no original)

Ou seja, o Nucci está sendo difamado pela inteligência artificial, sendo-lhe imputado um erro grosseiro que o autor (que vive da sua distinta capacidade intelectual) jamais cometeu! E sabe qual o mais maluco de tudo isso?? A citação que a IA coloca entre aspas não existe!!!

Procura aí em qualquer livro dele (eu tenho o Manual, o Curso e o Código comentado) e você não encontra! Joga no Google e não aparece! Ou seja, a IA fabricou uma citação “na faixa”, sem qualquer pudor ou decoro. E ainda se saiu com uma resposta de especialista, que na verdade está errada e não existe!

E causa um certo espanto (ou não!) que a IA tenha errado algo tão corriqueiro para quem é do Direito. Tais conceitos são os mesmos há cem anos! Nelson Hungria explicava essa miséria do mesmo jeito! Por que cargas d’água a IA errou algo tão objetivo e simples??

O motivo é tão simples quanto a matéria errada: tem um milhão de postagens na internet misturando de forma ridiculamente errada os conceitos de injúria, calúnia e difamação.

E onde é que a IA “aprende” as coisas para criar o seu conteúdo novo, rapidinho e bem diante dos seus olhos?? Pois é... o ChatGPT não é um bom frequentador de bibliotecas...

E daí vem uma discussão que foi levantada de forma muito contundente em 2017 pelo Fórum Econômico Mundial e que foi esquecida depois que o mundo acabou em 2020: sem regulação da fonte de aprendizado da inteligência artificial, como vamos poder confiar no resultado final do trabalho da IA?

Se não tem um mínimo para a fonte de aprendizado, como evitaremos que a IA seja burra e repita desinformação? Como vamos evitar que a IA seja racista, machista, misógina, xenófoba?

Uma pesquisa simples na internet e você descobre uma avalanche de conteúdos neste sentido e todos estão disponíveis para a IA “aprender”. O que vai impedir de a IA virar terraplanista?

Ou seja, tem um monte de informação burra na internet. Essa aí é só uma delas! É grosseira daquelas que você realmente questiona se quem a afirmou estudou minimamente a matéria. Mas tem gente que erra e essas pessoas são ruins tecnicamente, como sempre aconteceu na vida.

O problema é que gente ruim tecnicamente também publica na internet e também alimenta a inteligência artificial, dado que ela não sabe filtrar com tanta precisão o que é “bom” e o que é “ruim”. A IA assimila as informações por volumetria e similitude e “trata” essa base de informações para criar a sua própria inteligência.

Parêntesis 2: isso me faz recordar um sábio pensamento de uma mãe de coração que tive, que dizia que o argumento da experiência (muito utilizado por pessoas mais velhas para desqualificar o saber de gente mais jovem) é um argumento burro. E é burro simplesmente porque muitos anos de experiências ruins não qualificam ninguém para nada e simplesmente significam muitas experiências ruins.

Parêntesis 3: a inteligência artificial atua na coleta de dados da surface web. Ou seja, a web acessível para todos e que a gente acha com o google. De acordo com as grandes plataformas (CISO, KASPERSKY e etc), a surface web corresponde a cerca de 5% da informação gerada na internet. Ouso dizer, porém, que concentra 95% da informação inconsistente (e por isso perigosa) gerada na internet.

Voltando: Neste cenário é que se percebe que a IA não é capaz de superar o ser humano que sabe diferenciar calúnia, injúria e difamação igual foi ensinado pelos teóricos do direito em publicações verificadas. Ou seja, o especialista vai se tornando cada vez mais necessário!

Conversando com a minha amiga e comadre Flávia Carvalho, psicóloga especializada em educação e aprendizado, sobre o fato de que foi noticiado que alguns adolescentes estão utilizando o ChatGPT como psicólogo, descobri que o buraco é bem mais embaixo! Ela testou os conhecimentos da ferramenta e a colocou em uma situação que a IA precisava separar sentimentos de emoções.

Você já deve saber o resultado né? Errou de novo!

Parêntesis 4: você, por acaso, sabe a diferença entre sentimentos e emoções? Se você não tem formação específica, eu duvido muito que saiba algo muito mais elaborado do que o conteúdo de poema romântico que você leu na escola. É assim que se forma um leigo. Somos todos leigos da maioria das coisas.

Voltando: A IA vai tornar tudo mais incerto ao invés de prover segurança, dando resposta para tarefas objetivas e desafiando as mentes mais agudas para as tarefas complexas que a IA julga ser capaz de produzir!

A qualidade da fonte da informação das pessoas se torna cada vez mais importante e isso precisa ser feito por seres humanos. Ouso dizer, ainda, que mesmo para atividades simples a substituição não será tão dramática assim!

Acredito que os grandes conglomerados financeiros, varejistas e securitários veem com muito bons olhos a substituição dos seus advogados no contencioso de massa por robôs. Robôs não têm salário, não cansam, não cobram hora extra, não ficam com dor de barriga e nem terminam o namoro e ficam chateados e com isso menos produtivos.

Ou seja, essa galera vai rodar e vai rodar feio. Milhões de processos todos iguais, com alteração de nome e endereço. Óbvio que o trabalho via robô é mais interessante.

Agora inverte o raciocínio. Para de pensar no banco, que tem 2 milhões de processos em tramitação simultânea, e pensa na d. Maria. Sabe quem é a d. Maria? Uma das 2 milhões de pessoas que ajuizaram ação contra o banco porque a inteligência artificial do banco lançou o nome dela no SPC sem ela dever nem um real sequer (baita inteligência...).

Ela vai contratar um robô? O robô vai saber a ouvir e entender a sua angústia de viver de salário, ter apenas o nome limpo como principal bem e não conseguir comprar uma TV parcelada por causa de uma anotação indevida? Acho muito pouco provável.

E talvez essa pessoa capaz de ouvir a d. Maria, vai saber a acolher e dar o conforto de que algo está sendo feito. Logo depois vai abrir o ChatGPT e tirar dali uma petição que vai usar de forma crítica (ou não!) e vai ajuizar a ação contra o banco para o advogado robô contestar.

Não tardará o dia em que as sentenças também terão a sua parcela de produção por IA, se é que já não têm. Vale lembrar que, já há alguns anos, a maioria dos recursos do STF é julgada por IA. A questão é que as pessoas serão realocadas, mas não substituídas.

E mais do que nunca os cérebros artesanais serão precisos e preciosos! Até porque precisamos debater com qualidade quem vai indenizar o Nucci por isso...