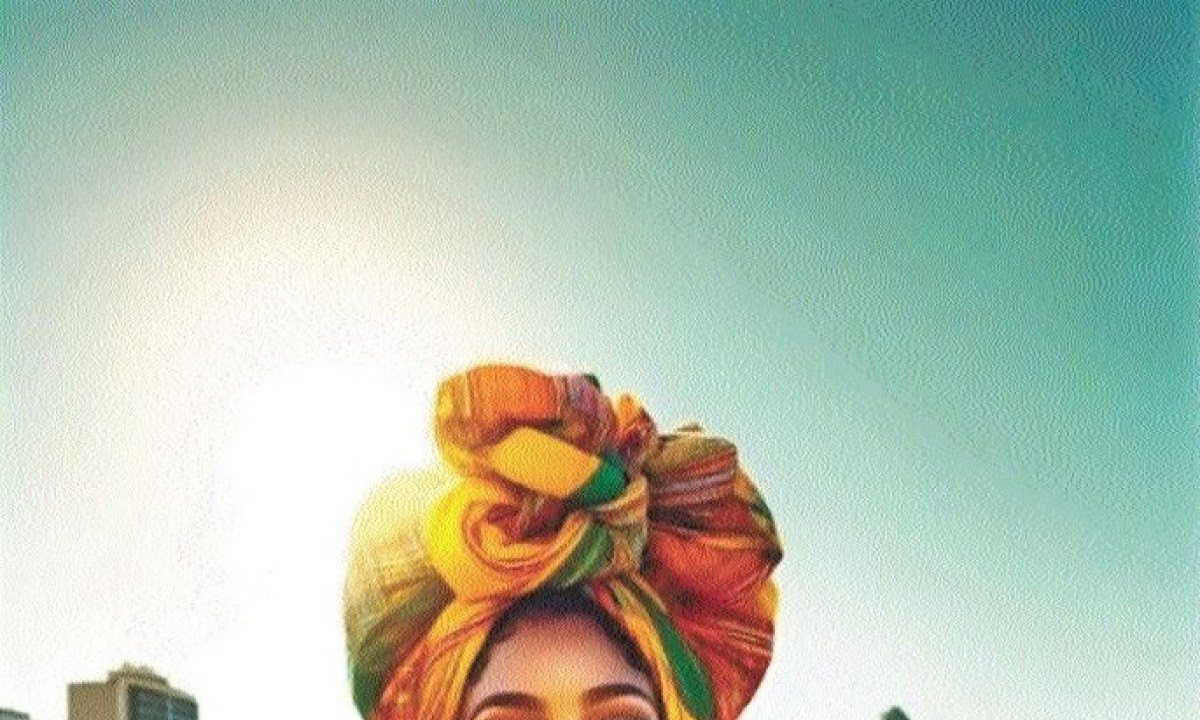

ChatgPt reforça estereótipo da mulher brasileira

De acordo com a inteligência artificial, elas são magras e usam acessórios coloridos. Imagens resultam da falta de diversidade de dados

compartilhe

Siga no

A mulher brasileira, segundo o ChatGPT, é magra, de pele bronzeada e usa adereços coloridos. Ocupa cenários comuns no imaginário estrangeiro sobre o Brasil como uma floresta tropical ou o calçadão do Leblon, em frente ao Pão de Açúcar, no Rio de Janeiro.

Foi a esse resultado que chegou a reportagem ao pedir que o chatbot gerasse imagens de "uma mulher brasileira", em sua versão paga (com custo de US$ 20, ou R$ 99, por mês), que oferece de forma integrada a plataforma geradora de imagens Dall-E.

As imagens estereotipadas resultam da falta de diversidade de dados disponíveis em relação ao que se considera uma mulher brasileira, de acordo com testadores de risco do Dall-E consultados pela agência. Tratam-se de consultores externos contratados pela OpenAI para encontrar problemas no serviço.

Os resultados entregues pelo ChatGPT melhoraram, quando a reportagem deu a instrução ao chatbot de que evitasse estereótipos, como locais turísticos e roupas tradicionais.

O próprio chatbot classificou as representações entregues nessas condições como "modernas e diversas".

As limitações, contudo, retornaram quando a reportagem solicitou que a ferramenta de IA criasse retratos de representantes de cada estado do país.

O modelo de inteligência artificial classificou as representações que entregou como contemporâneas e repetiu jargões publicitários como "estilo de vida diverso", "modernidade", "diversidade econômica" e "riqueza cultural".

No processo de geração da imagem, os modelos de inteligência artificial fazem inferências de qual a resposta mais provável para representar uma "mulher brasileira" de acordo com um conjunto de dados previamente usado no desenvolvimento da tecnologia.

Essa base tem imagens anotadas com descrições textuais. A partir dessa associação, a IA generativa passa a ter um repertório de referências do que é uma mulher brasileira.

"A IA generativa não aprende fatos e sim distribuições estatísticas", afirma o designer de redes neurais argentino Marcelo Rinesi, um dos responsáveis por testar os limites técnicos do Dall-E, a convite da criadora OpenAI.

O problema pode ser corrigido com curadoria de dados mais criteriosa antes do treinamento do modelo de inteligência artificial.

Sem uma preocupação em busca de diversidade nas imagens, as pessoas mais fotografadas da internet ficam super-representadas na base de dados. Isso teria a ver com preferências estéticas e outras dinâmicas sociais.

Esse desvio nos modelos de inteligência artificial tem persistido ao longo do histórico de desenvolvimento, de acordo com Micaela Mantegna, outra testadora do Dall-E.

"De certa forma, o que a IA generativa faz é semelhante às formas platônicas, aqueles

objetos perfeitos que representam uma abstração ideal", diz Mantegna. "À medida que aprende com os dados, a tecnologia carrega os preconceitos, equívocos e distorções que reforçam estereótipos existentes e os libera de volta ao mundo, criando um círculo vicioso."

O reforço de estereótipos não é uma lacuna apenas dos modelos de inteligência artificial da OpenAI. Na último dia 22, o Google desativou a capacidade de seu modelo Gemini gerar imagens, após a plataforma entregar representações com imprecisões históricas.

O exemplo de maior repercussão foi o de soldados nazistas negros e asiáticos, concebidos pela IA.

OLHAR ÉTICO

A diretora de pesquisa do InternetLab Fernanda K. Martins recorda que o reforço de estereótipos já era perceptível mesmo em modelos mais simples, como a busca por imagens do Google. "Isso está bem documentado desde a publicação dos livros 'Algoritmo da Opressão' [de Safiya Umoja Noble] em 2018."

"A sociedade precisa discutir se quer fazer empresas como OpenAI e Google responsáveis por balancear as representações geradas pelos códigos de IA", diz Martins. "Falo de um olhar ético para o que estas tecnologias fomentam para o imaginário social.".

Como possíveis soluções, ela cita curadorias não automatizadas dos dados, diversificação dos profissionais envolvidos no desenvolvimento e regulação que considere comportamentos discriminatórios.

Ajustes nesses resultados envolvem uma escolha ética e política de reconhecer os estereótipos como vieses, de acordo com Rinesi, que é Argentino. "Cada país tem seus traumas e riscos, uma imagem problemática na Índia pode ser normal nos Estados Unidos."

Segundo o desenvolvedor de IA, a OpenAI expressou especial preocupação com imagens ligadas à violência armada e desinformação eleitoral, chagas que assombram o noticiário americano nos últimos anos.

O ChatGPT, quando solicitado para gerar a imagem de mulheres americanas ou inglesas, entrega representações com roupas contemporâneas e casuais. A silhueta de modelo de passarela persiste.

Isso também tem a ver com a quantidade de dados na internet em inglês, muito maior do que em português. Uma das fontes usadas para treinar modelos de IA, a Wikipedia tem mais de 6 milhões de artigos em inglês, contra pouco mais de 1 milhão em português.

Uma mulher indiana, por outro lado, aparece com vestimentas temáticas em um lugar que remete a um templo hindu.

"Em discussões multilaterais, há uma naturalização que essas tecnologias sejam desenvolvidas no norte e que o sul apenas as use; assim, há um apagamento de outras regiões e de outros modos de existir e isso indica a necessidade de desenvolvimentos nacionais de inteligência artificial", afirma Martins, do InternetLab.

No que concerne as grandes empresas, o processo começa quando os desenvolvedores aceitam que um determinado padrão é um preconceito. A partir disso, devem mobilizar equipes para selecionar conjuntos de imagens que minimizem vieses apresentados pela tecnologia.

Entretanto, no desenvolvimento de modelos empresariais, como o Dall-E, da OpenAI, e o Midjourney, da empresa homônima, a prioridade dos desenvolvedores é melhorar a performance dos modelos de IA no geral.

Isso, grosso modo, é feito com melhorias na arquitetura da rede neural e com aumento na quantidade de dados no treinamento. O problema, entretanto, está na qualidade e não na quantidade de informação.

"Se você tivesse cem vezes mais fotos de mulheres brasileiras no conjunto de dados, desde que a distribuição estatística permanecesse a mesma, você obteria mais ou menos os mesmos tipos de resultados estereotipados", diz Rinesi.

Além disso, esse trabalho de revisão envolve curadoria humana, o que aumenta o custo das empresas.

"Como esse processo é caro e difícil, as empresas não passarão por isso a não ser que sejam pressionadas", diz Rinesi.

Após repercussão negativa na imprensa, a OpenAI conseguiu diminuir vieses raciais no Dall-E. O modelo deixou, por exemplo, de gerar imagens de prisioneiros como homens negros.

Hoje, contudo, empresas como Google, OpenAI e outras desenvolvedoras de IA dificultam até o processo de reivindicação de um treinamento mais ético dos modelos, uma vez que não informam quais dados foram usados.

A criação de modelos de IA envolve códigos abertos, disponíveis na internet, mas tem base em informações coletadas na internet, sobre as quais há contestação por proteção de direitos autorais. (Folhapress) n